Tekoälyn potentiaali esimerkiksi lääketieteessä on valtava. Samaan aikaan tekoälyn läpinäkymättömyys on usein ristiriidassa tieteen periaatteiden kanssa.

Joulukuussa 2023 Nature-lehdessä julkaistiin Massachusetts Institute of Technologyn ja Harvardin yliopiston tutkimus, jossa tutkijat löysivät tekoälyn avulla uuden antibioottiluokan. Tekoälyn avulla on toki ennenkin kehitetty uusia kemiallisia yhdisteitä, mutta ongelmana on usein ollut se, ettei tekoälymallin toimintaperiaatteista ole saatu tarkkaa tietoa. Tästä syystä tutkimuksia on ollut lähes mahdotonta toistaa.

Tutkijat kertoivat käyttäneensä ”selitettävää syväoppimismallia”. Se tarkoittaa edistynyttä itseoppivaa tekoälyjärjestelmää, jonka toimintalogiikka on tutkijoiden tiedossa. Tällainen läpinäkyvyys mahdollistaa tarkan tiedon saamisen, mikä taas vahvistaa tutkimuksen luotettavuutta ja toistettavuutta.

Tässä artikkelissa avataan, mitä läpinäkyvyys tekoälyssä tarkoittaa ja miksi se on tärkeää tutkimustyössä. Artikkelissa käydään läpi käytännön tutkimustyön kannalta merkittäviä asioita, joita jokaisen tekoälystä kiinnostuneen tutkijan olisi hyvä pohtia.

Mikä ihmeen läpinäkyvä tekoäly?

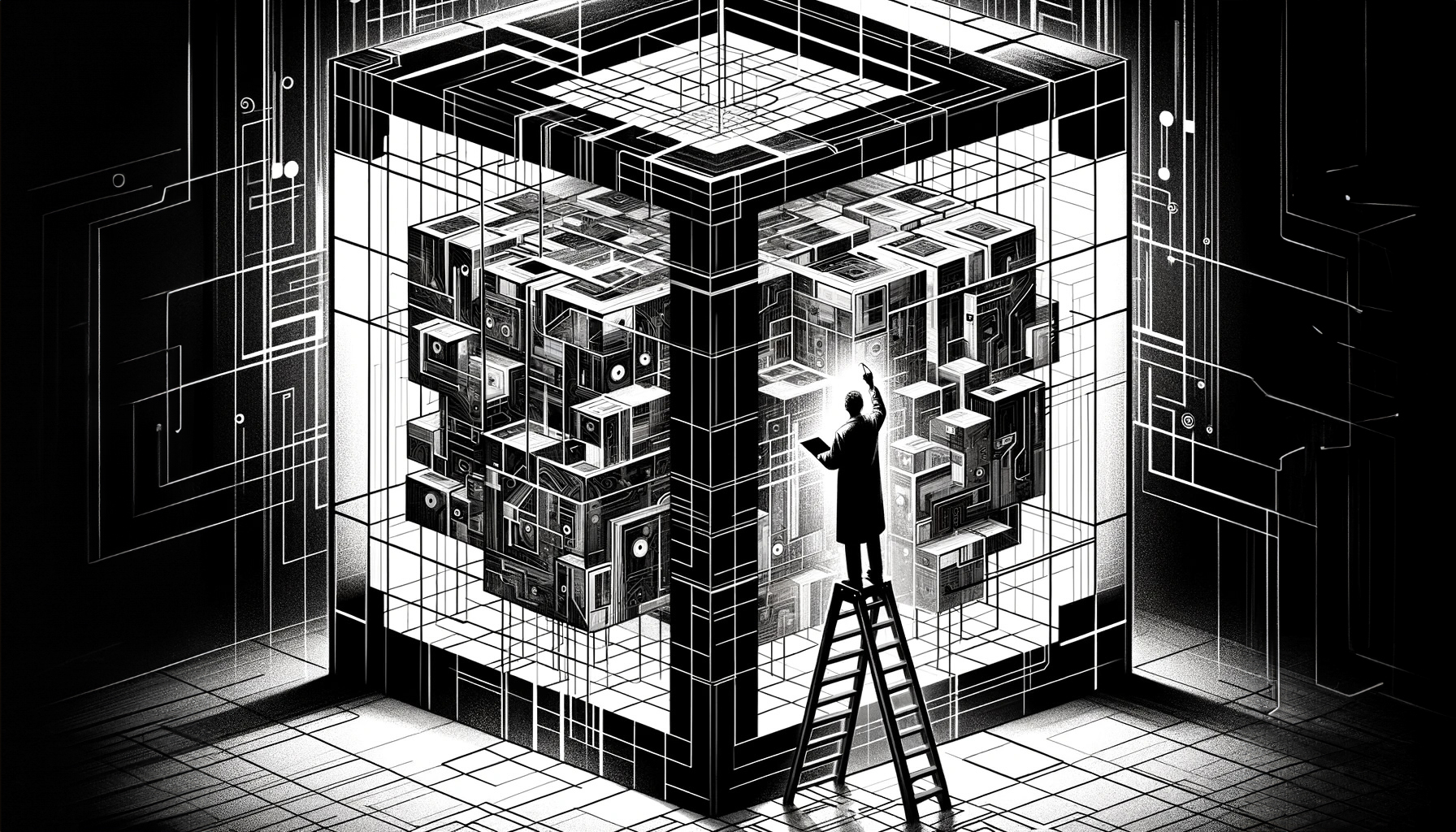

Suurin osa kohtaamistamme tekoälypalveluista on vertauskuvallisesti mustia laatikoita, eli niiden toimintaperiaatteet ovat salaisia. Toisin sanoen ne eivät ole läpinäkyviä, emmekä siksi tiedä, miten ne tarkalleen ottaen toimivat. Ikään kuin Kalevalassa esiintyvä ihmekone Sampo, joka jauhaa ruokaa ja rikkauksia, mutta kukaan ei tiedä miten. Monelle meistä myös älypuhelin ja henkilöauto ovat mustia laatikoita.

Läpinäkyvyys on mustan laatikon vastakohta: voimme tarkastella, mitä laatikon sisällä tapahtuu. Jotta tekoäly olisi täysin läpinäkyvää, tulisi tietää sen lähdekoodi, koulutusdata ja miten algoritmia on säädetty kehitysvaiheessa.

”Selitettävän tekoälyn käyttäjä voi ymmärtää, miten tekoäly on päätynyt tulokseensa. Näin ollen käyttäjä voi helposti arvioida tekoälyn luotettavuutta.”

Harva meistä kuitenkaan ymmärtäisi juuri mitään esimerkiksi ChatGPT:n lähdekoodista, vaikka se tekisikin sovelluksen toiminnasta läpinäkyvää. Tästä syystä myös tekoälyn selitettävyys on oleellista. Selitettävän tekoälyn käyttäjä voi ymmärtää, miten tekoäly on päätynyt tulokseensa. Näin ollen käyttäjä ymmärtää tekoälyn loogisen päättelyketjun ja voi helposti arvioida tekoälyn luotettavuutta.

Tekoälysovellusten läpinäkyvyys ja toimintaperiaatteiden selitettävyys ovat tärkeitä vaatimuksia. Teknisten toimintaperiaatteiden tunteminen auttaa ymmärtämään mitä sovellukselta voidaan odottaa. Näin ollen voidaan arvioida sovelluksen potentiaalia esimerkiksi poliittisen päätöksenteon tai tutkimuksen tukena.

Miksi tekoälysovellukset eivät ole läpinäkyviä?

Läpinäkyvä ja selitettävä tekoäly kuulostaa kaikin puolin hyvältä ajatukselta. Miksi tekoälysovellukset sitten ovat useimmiten mustia laatikoita?

Ensinnäkin tekoälyä kehittävät yleensä yritykset, joiden tavoitteena on tehdä rahaa ohjelmistoillaan. Siksi ne varjelevat lähdekoodejaan kuin Coca-Cola kasvisuutejuomansa tarkkaa reseptiä. Vastaavasti avoimen koodin ohjelman voisi kuka vain kopioida ja muokata siitä oman versionsa.

Toinen syy läpinäkymättömyyteen piilee tavassa, jolla tekoälyä kehitetään. Modernit tekoälymallit perustuvat koneoppimiseen eli ne kouluttavat itse itsensä niille syötettävän koulutusdatan perusteella ilman ihmisen jatkuvaa ohjausta. Esimerkiksi laajat kielimallit kehitetään tällä tavalla, jolloin niiden toimintaa on lopulta mahdotonta täysin ymmärtää.

Syväoppimismallit ovat ihmisaivojen toimintaperiaatteita jäljittelevistä neuroverkoista kerrostettuja äärimmäisen monimutkaisia tekoälyjärjestelmiä. Ne ovat erittäin tarkkoja ja tehokkaita, mutta jo silkan monimutkaisuutensa takia hyvin vaikeita selittää.

”Teknologiayritysten johtajat ovat jo pitkään uskoneet tekoälymallin olevan sitä tarkempi, mitä huonommin ihmiskäyttäjä sen tuntee.”

Teknologiayritysten johtajat ovat jo pitkään uskoneet tekoälymallin olevan sitä tarkempi, mitä huonommin ihmiskäyttäjä sen tuntee. Systemaattiseen analyysiin perustuneessa tutkimuksessa havaittiin väitteen pitävän paikkansa 70 prosentissa tutkituista tapauksista. Suurimmassa osassa tapauksista ero jäi pieneksi.

Mustia laatikoita perustellaan myös turvallisuudella. ChatGPT:n kehittäjä OpenAI perustelee suljettua malliaan sillä, että läpinäkyvyys parantaa mahdollisuuksia väärinkäyttää järjestelmää. Tämä pätee mihin vain teknologiaan: mikäli tunnet teknologian kuin omat taskusi, voit manipuloida sitä toimimaan ikävään tarkoitukseen helpommin kuin tietämätön käyttäjä.

Miten tämä kaikki liittyy tieteeseen?

Tieteen kentällä on sitouduttu avoimen tieteen periaatteisiin, joihin kuuluu muun muassa käytettyjen tutkimusmenetelmien avaaminen sekä niiden rajoitteiden arviointi. Tutkimuksessa läpinäkyvyys on yksi keskeisistä eettisistä periaatteista. Tutkijan täytyy kuvata avoimesti ja luotettavasti tutkimustuloksiin johtanut prosessi ja perustella tulostensa tulkinta. Avoimuus mahdollistaa tutkimuksen toistettavuuden ja vahvistaa tieteellistä uskottavuutta.

Jos tutkimuksessa käytetään tekoälytyökaluja tutkimusinstrumenttina, näiden työkalujen toiminta pitäisi pystyä luotettavasti avaamaan tutkimuksen raportoinnin yhteydessä. Mustan laatikon tavoin toimivien tekoälytyökalujen hyödyntäminen tutkimuksen yhteydessä voi tästä syystä olla ongelmallista.

”Jos tutkimuksessa käytetään tekoälytyökaluja tutkimusinstrumenttina, näiden työkalujen toiminta pitäisi pystyä luotettavasti avaamaan tutkimuksen raportoinnin yhteydessä.”

Läpinäkyvä tekoälymalli on sellainen, jonka koulutusdata on tiedossa. Näin ollen mallin mahdolliset vinoumat ovat peräisin koulutusdatasta. Tutkijoiden tulee voida arvioida tekoälymallin vinoumia, ottaa ne huomioon tutkimusasetelmassa ja pyrkiä ehkäisemään niiden vaikutuksia tutkimustuloksiin.

Mustaan laatikkoon kätketyn teknologian hyödyntäminen on tässäkin suhteessa ongelmallista, sillä teknologian sisäänrakennetuista rajoitteista ei voi olla täysin varma. Mikäli taas algoritmin toiminta tunnetaan hyvin, menetelmän rajoitteita on helpompi arvioida.

Luovuus ei ole läpinäkyvää

Tutkimusartikkelin kirjoittaminen on luovaa työtä, joka ei ole luonteeltaan yhtä systemaattista kuin aineiston keruu ja analysointi. Kirjoitusvaiheessa esimerkiksi tutkimustekstin uusia käsitteitä ja metaforia koskevat ideat syntyvät tutkijan aivoissa monimutkaisten assosiaatioketjujen kautta. Hyvät ideat voivat syntyä lenkkipolulla, saunan lauteilla tai satunnaisen keskustelun yhteydessä.

ChatGPT:n kaltaiset kielimallisovellukset soveltuvat erinomaisesti ideoiden kehittelyyn. Chattibotin kanssa voi keskustella aiheesta kuin aiheesta, hieman kuin kollegan tai ystävän kanssa. Keskustelusta voi saada inspiraatiota tai ideoita asioiden ilmaisemiseen sekä näkökulmien tai käsitteiden valintaan.

”Tutkimustyön luova vaihe on luonnostaan eräänlainen musta laatikko.”

Luovuus ei ole seurausta loogisesta päättelyketjusta, eivätkä luovien ajatusten taustalla olevat assosiaatioketjut ole läpinäkyviä. Tutkimustyön luova vaihe on luonnostaan eräänlainen musta laatikko. Koska tämä vaihe on perinteisestikin läpinäkymätön, ChatGPT:n hyödyntäminen ei muuta asiaa suuntaan tai toiseen.

Joka tapauksessa on tutkijan vastuulla hahmottaa, missä tilanteissa ja työvaiheissa tekoälytyökalun käyttäminen voi uhata avoimen tieteen periaatteita. Toisaalta voi kysyä, kuuluuko asian olla näin? Yliopistot ovat julkaisseet opiskelijoille ohjeistuksia tekoälyn käytöstä. Selkeitä tutkijoille suunnattuja ohjeita ovat julkaisseet vasta Turun ja Itä-Suomen yliopistot. Olisiko muidenkin yliopistojen aiheellista linjata vastaavia ohjeita?

Antti Kailio

Asiantuntija, tiede ja päätöksenteko

Artikkeli on laadittu osana Jane ja Aatos Erkon säätiön rahoittamaa Tieteelliset Ilmiökartat -hanketta. Hankkeessa etsitään uusia ratkaisuja siihen, miten tieteen vaikuttavuutta voidaan edistää ja miten tutkittua tietoa saadaan tehokkaasti kanavoitua päätöksenteon tueksi. Julkaisemme kevään aikana sarjan tekoälyyn liittyviä artikkeleita, jotka avaavat tekoälyn hyödyntämisen potentiaalia ja rajoitteita. Lue lisää Tieteelliset ilmiökartat -hankkeesta.

Tekoälyn keskeistä sanastoa

Tekoäly = Tietokoneohjelman kyky suorittaa itsenäisesti tehtäviä, jotka perinteisesti ovat vaatineet ihmisälyn ominaisuuksia, kuten oppimista, päättelyä, sopeutumista, päätöksentekoa ja luovuutta.

Koneoppiminen = Tekoälyn alaryhmä. Koneoppimisessa järjestelmä parantaa suorituskykyään oppimalla itsenäisesti datasta ilman erillisiä toimintaohjeita. Suurin osa tekoälysovelluksista perustuu koneoppimiseen.

Kielimalli = Kielimalli on tilastollinen tekoälyjärjestelmä, joka ennustaa sanojen ja lauseiden esiintymisen todennäköisyyksiä sekä mahdollistaa luonnollisen kielen käsittelyn ja tuottamisen.

Neuroverkko = Ihmisaivoja jäljittelevä tietojenkäsittelyn, matematiikan tai laskennan malli. Neuroverkot ovat koneoppimisen keskeinen komponentti.

Koulutusdata = Koneoppimisessa koulutettavalle tekoälymallille syötettävä data, jonka perusteella malli oppii asioita.

Syväoppiminen = Edistynyt koneoppimisen menetelmä, joka hyödyntää kerrostettuja neuroverkkoja. Käytetään esimerkiksi puheen- ja kuvantunnistuksessa.

Algoritmi = Yksityiskohtainen toimintaohje, jota seuraamalla tietokone suorittaa tietyn tehtävän tai prosessin. Koneoppiva algoritmi muuttuu sen käyttämän syötedatan perusteella.